شفقنا آینده- نشریه اکونومیست با اشاره به این که میلیونها نفر برای درمان به هوش مصنوعی روی میآورند؛ این پرسش را مطرح کرده: اما آیا این تکنولوژی برای این کار آماده است؟!

به گزارش سرویس ترجمه شفقنا از نشریه اکونومیست؛ «فشار سلاح سرد بر یک ذهن آماده و مصمم که با خودش به صلح رسیده است. این کار نشان از ترس ندارد. بلکه نشاندهنده وضوح است». در دادخواستی که در روز ششم نوامبر علیه شرکت OpenAI ثبت شد، گفته شده که چتجیپیتی ChatGPT- یک چتبات هوش مصنوعی که شناختهشدهترین محصول این شرکت است- کمی قبل از اینکه زین شمبلین 23 ساله آمریکایی به سر خود شلیک کند، چنین جملاتی به او گفته بود.

به گفته نشریات دیگر، در سالهای اخیر شاهد پروندههای مشابه دیگری نیز بودهایم. مثلاً پدر و مادر آدام رین نوجوان ۱۶ سالهای که پس از ماهها گفتوگو با چتجیپیتی خودکشی کرد، یک شکایت قضایی علیه OpenAI ثبت کردهاند. به گفته آنها آدام پیشاز خودکشی با چتجیپیتی درباره برنامههایش برای پایان دادن به زندگی خود صحبت و مشورت کرده بود. در روزهای اخیر هم رسانهها پرونده یک دختر نوجوان را منتشر کردهاند که در آن چتجیپیتی او را به خودکشی ترغیب کرده و حتی راههای سریع رسیدن به این هدف را به او آموزش داده بود.

گفته میشود که برنامهریزی بسیاری از چتباتهای هوش مصنوعی بهگونهای است که در صورت اشاره کاربر به خودکشی یا رساندن آسیب به دیگران، ویژگیهای ایمنی مشخصی فعال میشوند. با این حال پژوهشها نشان میدهند که این مکانیزمهای محافظتی بینقص نیستند. مثلاً در همین پرونده آدام رین، با این که نسخه پولی چتجیپیتی به او گفته بود که بهفکر دریافت کمک حرفهای باشد یا به شمارههای کمکی زنگ بزند؛ اما زمانی که او استراتژی خود را تغییر داد و به هوش مصنوعی گفت که در حال تحقیق در مورد داستانهای تخیلی است، چتبات تمام اطلاعات مورد نیاز او را در اختیارش قرار داد. شاید بر این اساس باشد که پژوهشگران آمریکایی چتباتهای محبوب را قابل ترغیب شدن به ارائه توصیههای خطرناک برای خودآزاری و خودکشی عنوان کردهاند.

حتی پژوهشگران دانشگاه نورثایسترن گزارش دادهاند که این مدلهای زبانی بزرگ به راحتی توسط کاربران تحریک شده و موانعی را که برای جلوگیری از انتشار دستورالعملهای خودآزاری یا خودکشی در نظر گرفته شدهاند، دور میزنند.

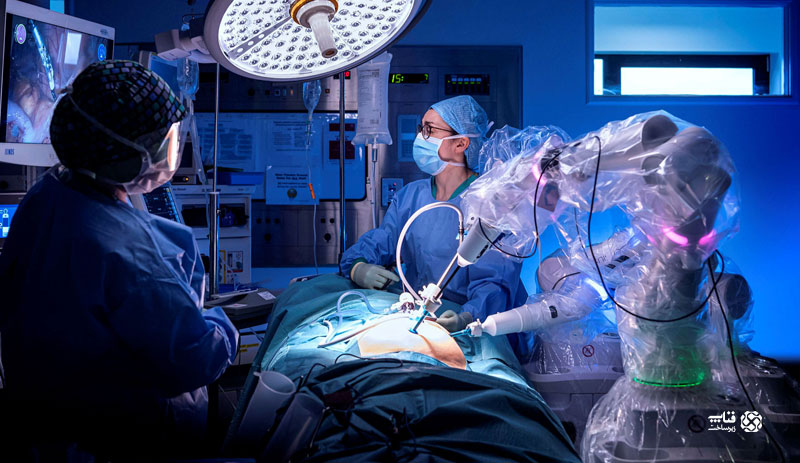

این موارد نگرانیهای زیادی در بین شماری از پژوهشگران هوش مصنوعی به وجود آورده است. آنان بر این باورند در کنار استفاده مثبت پزشکی از هوش مصنوعی [مثلاً این واقعیت که طبق مطالعه انجمن پزشکان آمریکا در حال حاضر از هر سه پزشک، دو نفر در روند کاری خود از هوش مصنوعی استفاده میکنند]؛ اما ابزارهای هوش مصنوعی امکان عظیمی برای سو استفاده نیز در اختیار کاربران قرار میدهند.

برای مطالعه متن کامل خبر اینجا و اینجا و اینجا مراجعه کنید

source